Wahrnehmung

Wahrnehmung ist für autonom agierende Roboter insofern zentral, da jegliche Aktionsplanung auf dem aus der Sensorik extrahierten Wissen basiert.

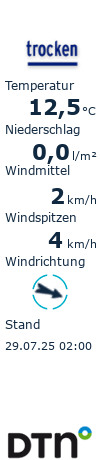

Informationen über den eigenen Zustand (Körperhaltung, Lage im Raum, usw.) gewinnen Roboter hauptsächlich über Beschleunigungssensoren, Gyroskope und Gelenkwinkelsensoren. Die gemessenen Sensorinformationen müssen geeignet zusammengeführt und gefiltert werden. Dies erlaubt dem Roboter, sich zum einen kontrolliert fortzubewegen, ohne die Balance zu verlieren, und zum anderen die aus anderen Sensorsystemen gewonnenen Informationen geeignet zu interpretieren.

Informationen über das Umfeld des Roboters werden auch aus Abstandssensoren (Sonar, Infrarot, Laser, usw.), aber hauptsächlich aus Kamerasystemen extrahiert. Dies muss in Echtzeit geschehen, also 20-30 mal pro Sekunde, um das flüssige Verfolgen schneller Bewegungen zu erlauben.

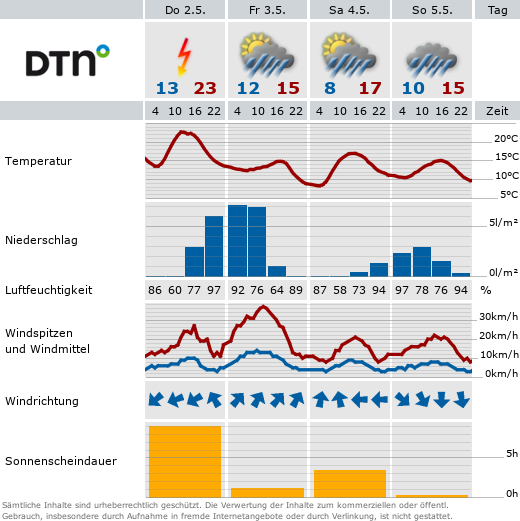

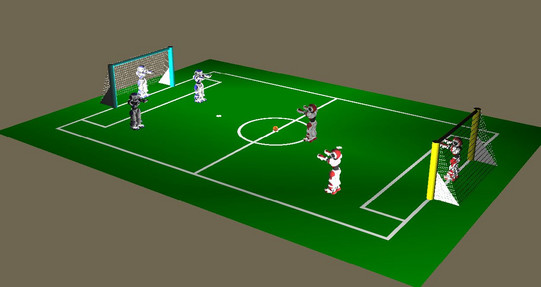

Um dies auf den vergleichsweise rechenschwachen CPUs der Standardroboter zu ermöglichen, ist die Farbgebung eines Roboterfußballfeldes genau spezifiziert. Ursprünglich waren auch zusätzliche künstliche Landmarken rund um das Feld platziert. Von Jahr zu Jahr wird diese Festlegung weiter aufgeweicht und die Herausforderung an die Wahrnehmungssysteme der Roboter erhöht. Neben dem Wegfall künstlicher Landmarken und dem Angleichen der Form der Tore an reale Fußballtore ist dies außerdem eine Lockerung der Beleuchtungssituation.

Effiziente Bildverarbeitung

Die schlechte Kamera des Aibos erschwert die Bildverarbeitung ungemein. Eine robuste Farbsegmentierung ist hier essentiell, um Informationen über relevante Objekte in Echtzeit extrahieren zu können. Die Kamera des Naos ist generell qualitativ hochwertiger, aber prinzipiell gelten auch hier die selben Einschränkungen, besonders auch im Hinblick auf die sehr eingeschränkte zur Verfügung stehende Rechenleistung.

Eine Generalisierung basierend auf Strahlungsmodellen hilft hier, die Farbsegmentierung gegen Beleuchtungsvariationen robuster zu machen.

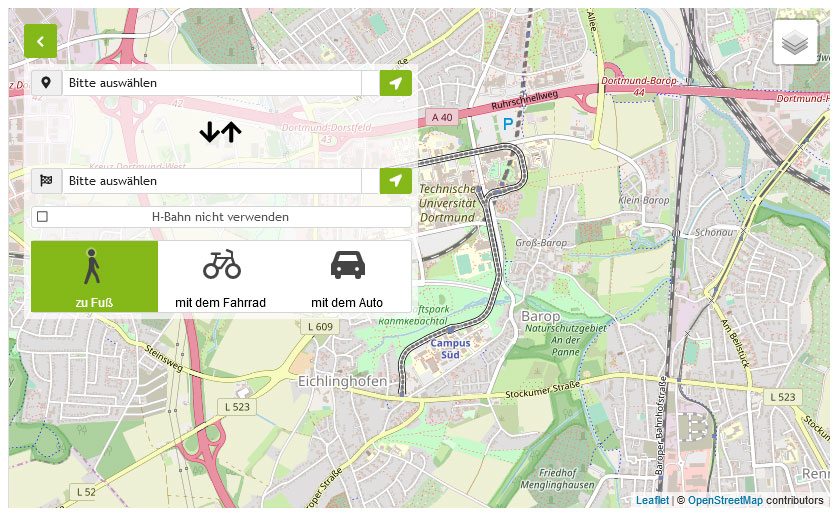

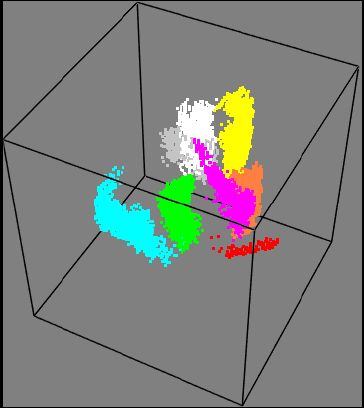

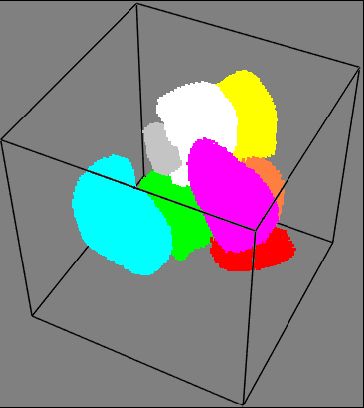

Einen weiteren Vorteil bietet Sensorfusion. In der Standard Platform League spielen drei bis vier Roboter in einem Team Roboterfußball. Die Roboter haben dabei die Möglichkeit, über wireless Lan miteinander zu kommunizieren. Damit ist es möglich, dass einer der Roboter nicht nur auf seine eigenen, sondern auch auf die Sensorinformationen der anderen Roboter zugreifen kann, um somit seine eigenen Informationen über seine Umgebung zu verbessern.

OmniVision

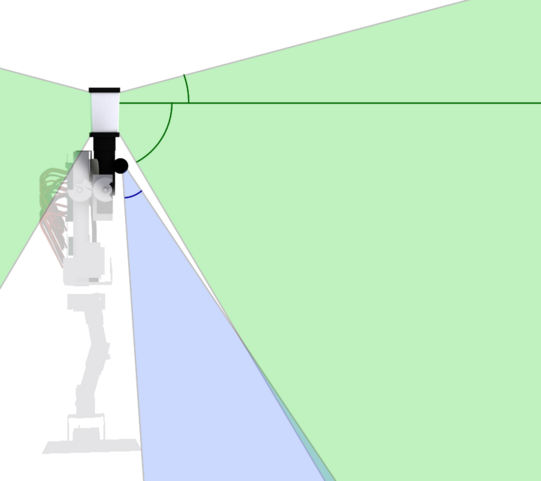

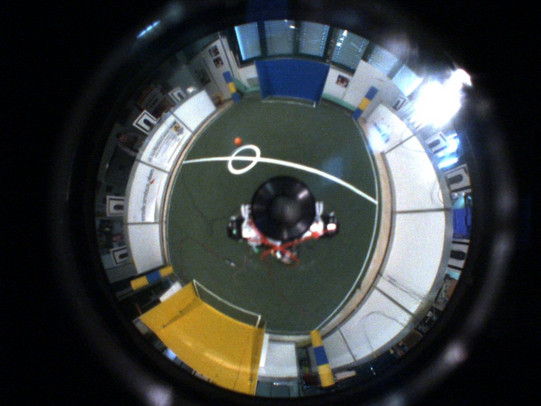

Als Kontrast zur sehr eingeschränkten Wahrnehmungsfähigkeit des Aibos haben wir uns bei der Konstruktion des humanoiden Roboters Bender dazu entschlossen, ein catadioptrisches Kameramodell (das also sowohl Licht brechende als auch reflektierende Elemente besitzt) einzusetzen. Hierdurch erlangt der Roboter ein nahezu omnidirektionales Blickfeld. Der blinde Fleck direkt vor dem Roboter kann zusätzlich durch eine kleine gerichtete Kamera abgedeckt werden.

Ein solchermaßen verzerrtes Bild kann über geeignete mathematische Modelle des Abbildungsprozesses wieder in einzelne perspektivische Ansichten oder auch eine Panoramaansicht zurückgerechnet werden.

Solch eine Umrechnung kostet allerdings kostbare Rechenzeit, sodass stattdessen das Wissen um die Geometrie des catadioptrischen Bildes in dessen direkte Verarbeitung einfließen sollte. Zusammen mit der aktuellen Lageschätzung des Roboters aus Gelenkwinkeldaten, Inertialsensoren und eben den aus dem letzten Bild extrahierten Informationen kann das Bild ohne vorherige Umrechnung extrem effizient verarbeitet und Informationen über alle relevanten sichtbaren Objekte in Echtzeit extrahiert werden.